最近,Deepseek 简直火爆出圈,引无数英雄竞折腰,大家都迫不及待地想体验它的强大功能。访问量太大,官方不得不暂停 API 充值,真是甜蜜的负担!😂 很多人(包括我)只能选择本地部署,但无奈个人设备性能有限,完整版大模型根本跑不动,光模型体积就让人望而却步。别担心,我这就来拯救你:通过代理官方客户端 API,曲线救国,免费用 Deepseek!更惊喜的是,用类似方法,还能白嫖其他九大厂商的大模型,简直不要太爽!🎉

🛠️ 神器速览:十大开源项目,助你零成本玩转大模型 💰

这套方案由同一位开发者贡献的 10 个开源项目组成,分别对应 10 家知名的大模型厂商。它巧妙地运用逆向工程,将官方客户端的大模型 API 接口免费开放。这些项目亮点满满:

- 🆓 零成本畅玩: 告别高昂 API 费用,尽情体验大模型的魅力。

- ✨ 功能全覆盖: 官方客户端有的功能,这里全都有,智能体、AI 绘图、联网搜索、深度思考等高级功能不在话下。

- ⚡ 一键式部署: 无需繁琐配置,快速上手,即刻体验。

- 🔑 多账号支持: 支持多个 Token,有效避免并发限制。

- 🤝 接口兼容性: 与 ChatGPT 接口完美兼容,无缝迁移,轻松上手。

🚀 部署起飞:Docker + Nginx,让大模型触手可及 ☁️

这 10 个项目都推荐使用 Docker 部署,并建议使用 Nginx 反向代理,然后集成到 one-api 或 new-api 中。最后,通过 LobeChat 等开源客户端接入 one-api 或 new-api 的 API,就可以开始畅游各大厂商的大模型啦。

1️⃣ 深度求索 Deepseek 🔍:探索AI的深度与无限可能

deepseek-free-api 通过逆向 DeepSeek,支持高速流式输出、多轮对话、联网搜索、R1 深度思考和静默深度思考,零配置部署,多路 token 支持。

🛠️ 启动方法

services:

deepseek-free-api:

container_name: deepseek-free-api

image: vinlic/deepseek-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

# - DEEP_SEEK_CHAT_AUTHORIZATION=你的Token # 将token配置在环境变量

保存为 docker-compose.yml,执行:

docker-compose up -d

🔑 使用方法

deepseek-free-api 提供与 OpenAI 兼容的 /v1/chat/completions 接口。

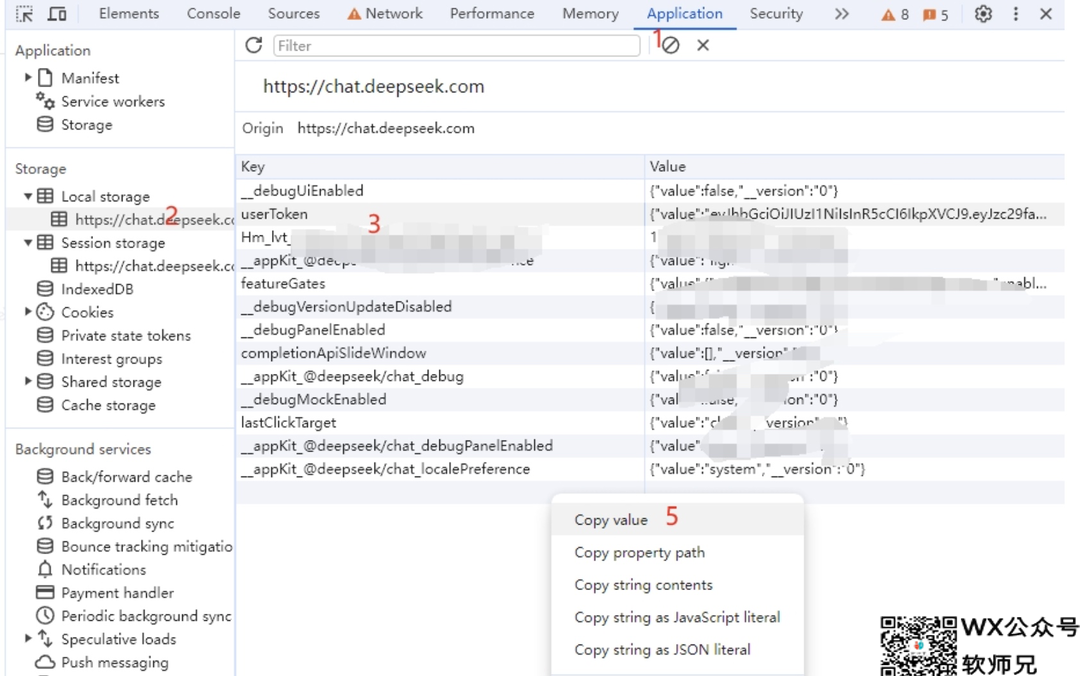

1、获取 DeepSeek userToken

- 访问 DeepSeek 并发起对话。

- F12 打开开发者工具,在

Application->LocalStorage中找到userToken,复制value值。

2、设置请求 Header

设置 Authorization 头部,值为 Bearer <你的userToken>。

Authorization: Bearer eyJhbGciOiJIUzUxMiIsInR5cCI6IkpXVCJ9...

3、发送请求

向 /v1/chat/completions 发送 POST 请求:

{

"model": "deepseek",

"messages": [

{

"role": "user",

"content": "你是谁?"

}

],

"stream": false

}

model 参数可选:

deepseek:默认模型。deepseek-think或deepseek-r1:深度思考模型。deepseek-search:联网搜索模型。deepseek-r1-search或deepseek-think-search:深度思考+联网搜索模型。deepseek-think-silent或deepseek-r1-silent或deepseek-search-silent:静默模式。deepseek-think-fold或deepseek-r1-fold:深度思考但思考过程可折叠。

messages 参数指定对话内容。

stream 参数指定是否使用流式响应。

4、接收响应

{

"id": "50207e56-747e-4800-9068-c6fd618374ee@2",

"model": "deepseek",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": " 我是DeepSeek Chat,一个由深度求索公司开发的智能助手,旨在通过自然语言处理和机器学习技术来提供信息查询、对话交流和解答问题等服务。"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 1,

"completion_tokens": 1,

"total_tokens": 2

},

"created": 1715061432

}

2️⃣ 月之暗面 Kimi 🌙:无限接近真相的AI伙伴

kimi-free-api 通过逆向工程 Kimi,支持高速流式输出、多轮对话、联网搜索、智能体对话、探索版、K1 思考模型、长文档解读、图像解析,零配置部署,多路 token 支持,自动清理会话痕迹。

🛠️ 启动方法

services:

kimi-free-api:

container_name: kimi-free-api

image: vinlic/kimi-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

保存为 docker-compose.yml,执行:

docker-compose up -d

🔑 使用方法

kimi-free-api 提供与 OpenAI ChatGPT API 兼容的 /v1/chat/completions 接口。

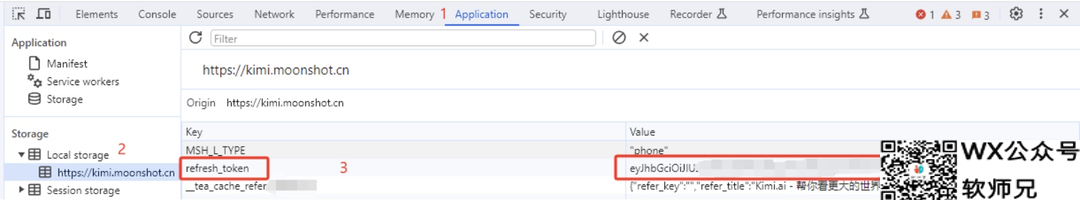

1、获取 refresh_token:

- 访问 kimi.moonshot.cn 登录 Kimi AI,打开开发者工具,在 Application -> Local Storage 中找到

refresh_token的值。

- 如果

refresh_token是一个数组,用.拼接起来。

2、设置 Authorization Header:设置 Authorization: Bearer [refresh_token]。

3、发起请求:向 /v1/chat/completions 发送 POST 请求:

{

"model": "kimi", // 模型名称,可选 kimi, kimi-search, kimi-research 等

"messages": [

{

"role": "user",

"content": "你好"

}

],

"use_search": false, // 是否开启联网搜索

"stream": false // 是否开启 SSE 流

}

4、接收响应

{

// 如果想获得原生多轮对话体验,此id,你可以传入到下一轮对话的conversation_id来接续上下文

"id": "cnndivilnl96vah411dg",

"model": "kimi",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "你好!我是Kimi,由月之暗面科技有限公司开发的人工智能助手。我擅长中英文对话,可以帮助你获取信息、解答疑问,还能阅读和理解你提供的文件和网页内容。如果你有任何问题或需要帮助,随时告诉我!"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 1,

"completion_tokens": 1,

"total_tokens": 2

},

"created": 1710152062

}

3️⃣ 智谱AI 💡:洞察世界的智能之光

glm-free-api 通过逆向智谱清言,支持 GLM-4-Plus 高速流式输出、多轮对话、智能体对话、Zero 思考推理模型、视频生成、AI 绘图、联网搜索、长文档解读、图像解析,零配置部署,多路 token 支持,自动清理会话痕迹。

🛠️ 启动方法

services:

glm-free-api:

container_name: glm-free-api

image: vinlic/glm-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

保存为 docker-compose.yml,执行:

docker-compose up -d

🔑 使用方法

glm-free-api 提供与 OpenAI 兼容的 /v1/chat/completions 接口。

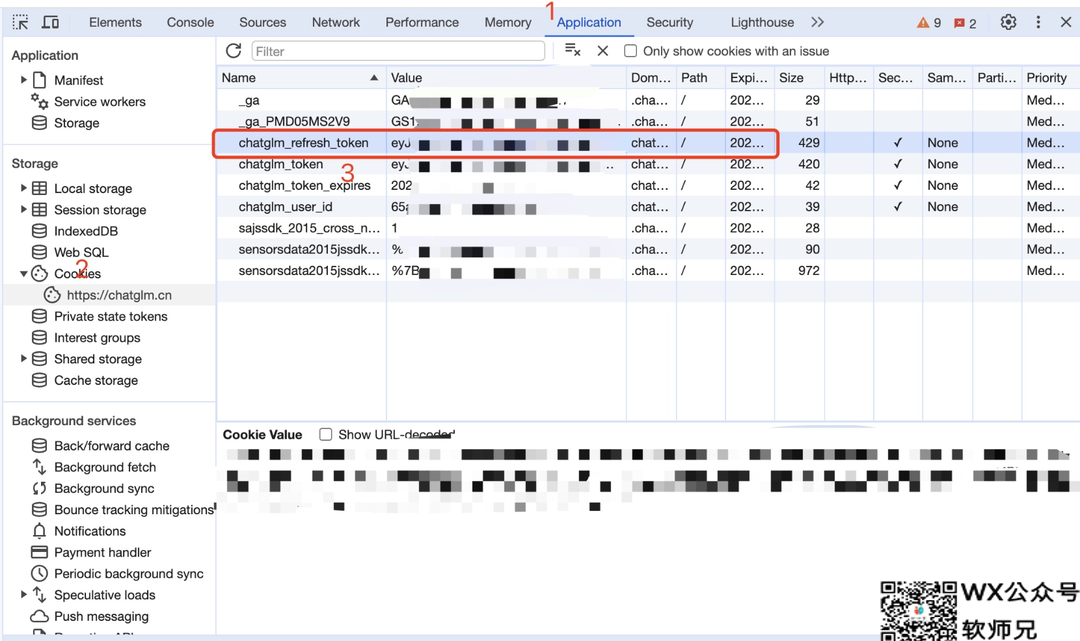

1、获取 refresh_token

- 访问 智谱清言 并发起对话。

- 打开开发者工具 (F12),在 Application -> Cookies 中找到

chatglm_refresh_token的值。

- 这个值将作为 Authorization 的 Bearer Token 值:

Authorization: Bearer TOKEN。

2、设置 Authorization Header:设置 Authorization: Bearer [TOKEN]。

3、发起请求:向 /v1/chat/completions 发送 POST 请求:

{

// 默认模型:glm-4-plus

// zero思考推理模型:glm-4-zero / glm-4-think

// 如果使用智能体请填写智能体ID到此处

"model": "glm-4-plus",

// 目前多轮对话基于消息合并实现,某些场景可能导致能力下降且受单轮最大token数限制

// 如果您想获得原生的多轮对话体验,可以传入首轮消息获得的id,来接续上下文

// "conversation_id": "65f6c28546bae1f0fbb532de",

"messages": [

{

"role": "user",

"content": "你叫什么?"

}

],

// 如果使用SSE流请设置为true,默认false

"stream": false

}

4、接收响应

{

// 如果想获得原生多轮对话体验,此id,你可以传入到下一轮对话的conversation_id来接续上下文

"id": "65f6c28546bae1f0fbb532de",

"model": "glm-4",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "我叫智谱清言,是基于智谱 AI 公司于 2023 年训练的 ChatGLM 开发的。我的任务是针对用户的问题和要求提供适当的答复和支持。"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 1,

"completion_tokens": 1,

"total_tokens": 2

},

"created": 1710152062

}

4️⃣ 阶跃星辰 🌠:探索未知的星辰大海

step-free-api 通过逆向跃问 StepChat,支持高速流式输出、多轮对话、联网搜索、长文档解读、图像解析,零配置部署,多路 token 支持,自动清理会话痕迹。

🛠️ 启动方法

services:

step-free-api:

container_name: step-free-api

image: vinlic/step-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

保存为 docker-compose.yml,执行:

docker-compose up -d

🔑 使用方法

step-free-api 提供与 OpenAI 兼容的 /v1/chat/completions 接口。

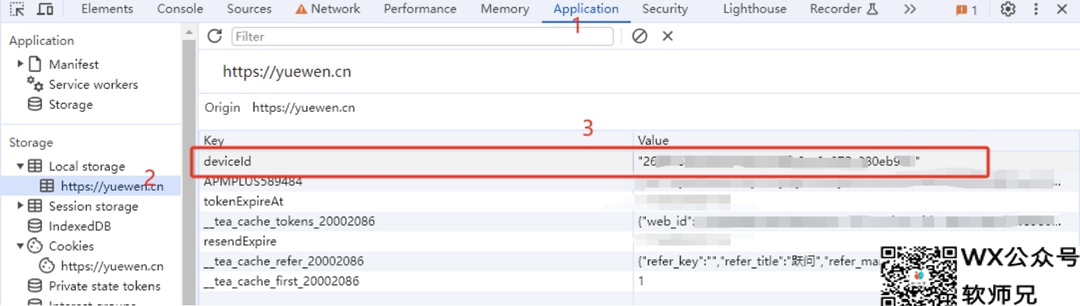

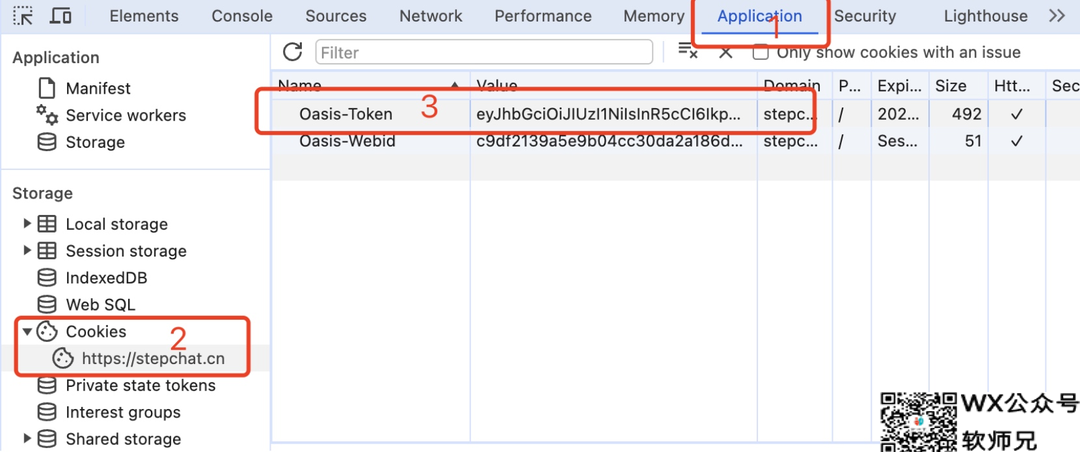

1、获取 Token

- 访问 跃问 StepChat 并发起对话,F12 打开开发者工具。

- 在 Application > LocalStorage 中找到

deviceId的值(去除双引号)。

- 在 Application > Cookies 中找到

Oasis-Token的值。

- 将

deviceId和Oasis-Token使用@拼接为 Token,作为 Authorization 的 Bearer Token 值。

2、设置 Authorization Header:设置 Authorization: Bearer [refresh_token]。

3、发起请求:向 /v1/chat/completions 发送 POST 请求:

{

"model": "step",

"messages": [

{

"role": "user",

"content": "你是谁?"

}

],

"stream": false

}

4、接收响应

{

"id": "85466015488159744",

"model": "step",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "我是跃问(StepChat),一个由阶跃星辰(StepFun)开发的多模态大模型。我可以回答您的问题,提供信息和帮助,同时支持多种模态的交互,如文字、图像等。如果您有任何问题或需要帮助,请随时向我提问。"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 1,

"completion_tokens": 1,

"total_tokens": 2

},

"created": 1711829974

}

5️⃣ 阿里通义 ☁️:通达万物,义无反顾

qwen-free-api 通过逆向 Qwen,支持高速流式输出、多轮对话、无水印 AI 绘图、长文档解读、图像解析、联网检索,零配置部署,多路 token 支持,自动清理会话痕迹。

🛠️ 启动方法

services:

qwen-free-api:

container_name: qwen-free-api

image: vinlic/qwen-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

保存为 docker-compose.yml,执行:

docker-compose up -d

🔑 使用方法

qwen-free-api 提供与 OpenAI 兼容的 /v1/chat/completions 接口。

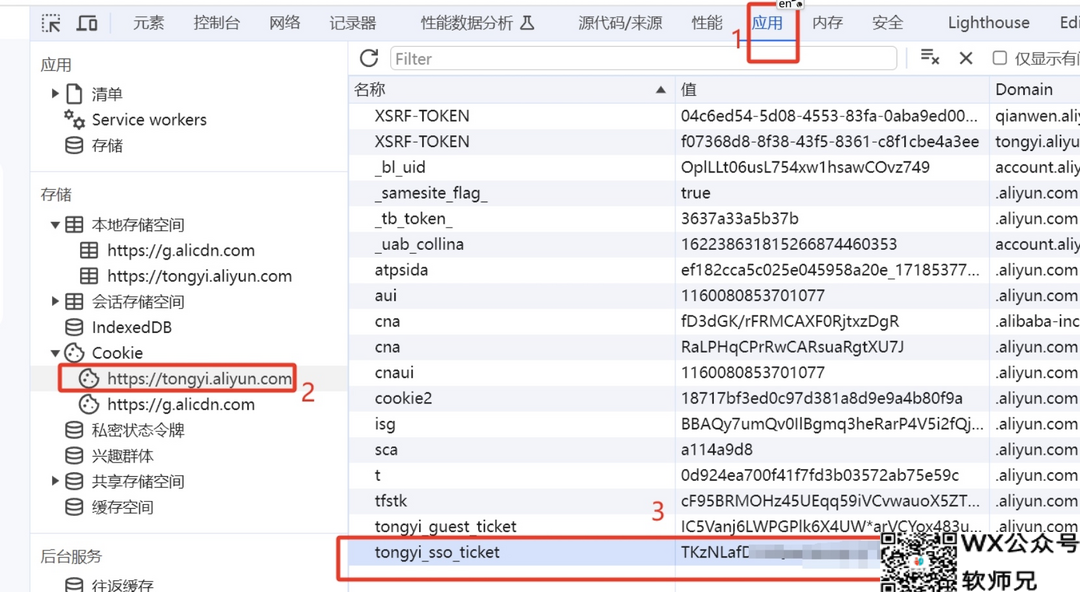

1、获取 Token

要使用 qwen-free-api,需要获取 tongyi_sso_ticket 或 login_aliyunid_ticket。

方法一:从通义千问获取

- 登录 通义千问。

- 发起对话。

- F12 打开开发者工具,从

Application -> Cookies中找到tongyi_sso_ticket的值。

方法二:从阿里云获取

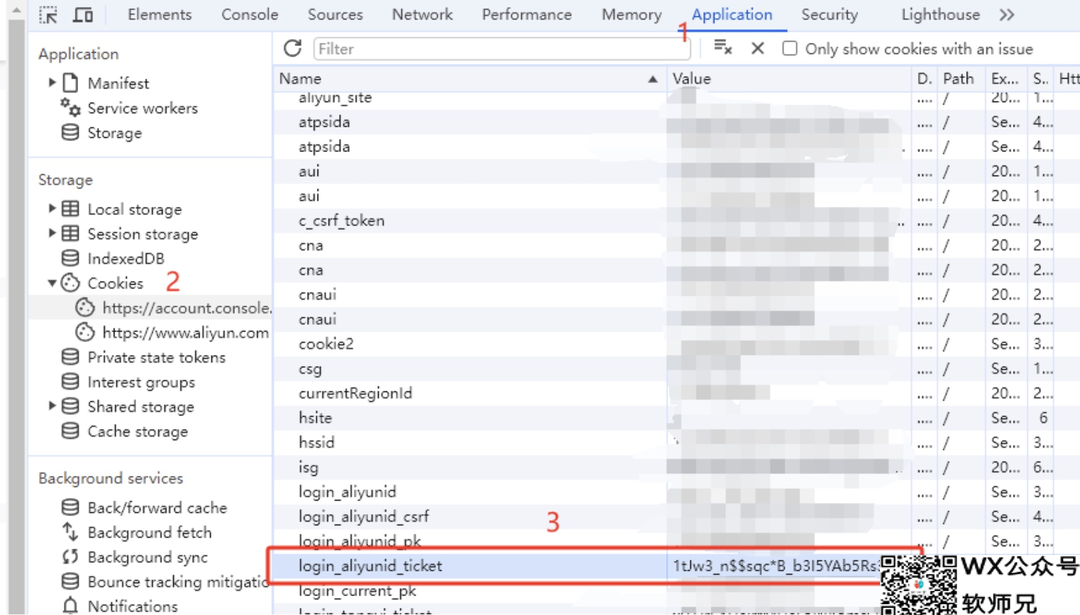

- 登录 阿里云(不建议在有重要资产的账号上操作)。

- 确保该账号之前进入过 通义千问 并同意协议。

- F12 打开开发者工具,从

Application -> Cookies中找到login_aliyunid_ticket的值。

2、设置 Authorization Header:设置 Authorization: Bearer [tongyi_sso_ticket/login_aliyunid_ticket]。

3、发起请求:向 /v1/chat/completions 发送 POST 请求:

{

// 模型名称随意填写

"model": "qwen",

// 目前多轮对话基于消息合并实现,某些场景可能导致能力下降且受单轮最大token数限制

// 如果您想获得原生的多轮对话体验,可以传入上一轮消息获得的id,来接续上下文

// "conversation_id": "bc9ef150d0e44794ab624df958292300-40811965812e4782bb87f1a9e4e2b2cd",

"messages": [

{

"role": "user",

"content": "你是谁?"

}

],

// 如果使用SSE流请设置为true,默认false

"stream": false

}

4、接收响应

{

// 如果想获得原生多轮对话体验,此id,你可以传入到下一轮对话的conversation_id来接续上下文

"id": "bc9ef150d0e44794ab624df958292300-40811965812e4782bb87f1a9e4e2b2cd",

"model": "qwen",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "我是阿里云研发的超大规模语言模型,我叫通义千问。"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 1,

"completion_tokens": 1,

"total_tokens": 2

},

"created": 1710152062

}

6️⃣ 秘塔AI 🔎:洞悉搜索的奥秘

metaso-free-api 通过逆向 Metaso,支持高速流式输出、多轮对话、联网搜索、智能体对话、探索版、K1 思考模型、长文档解读、图像解析,零配置部署,多路 token 支持,自动清理会话痕迹。

🛠️ 启动方法

services:

metaso-free-api:

container_name: metaso-free-api

image: vinlic/metaso-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

保存为 docker-compose.yml,执行:

docker-compose up -d

🔑 使用方法

metaso-free-api 提供与 OpenAI 兼容的 /v1/chat/completions 接口。

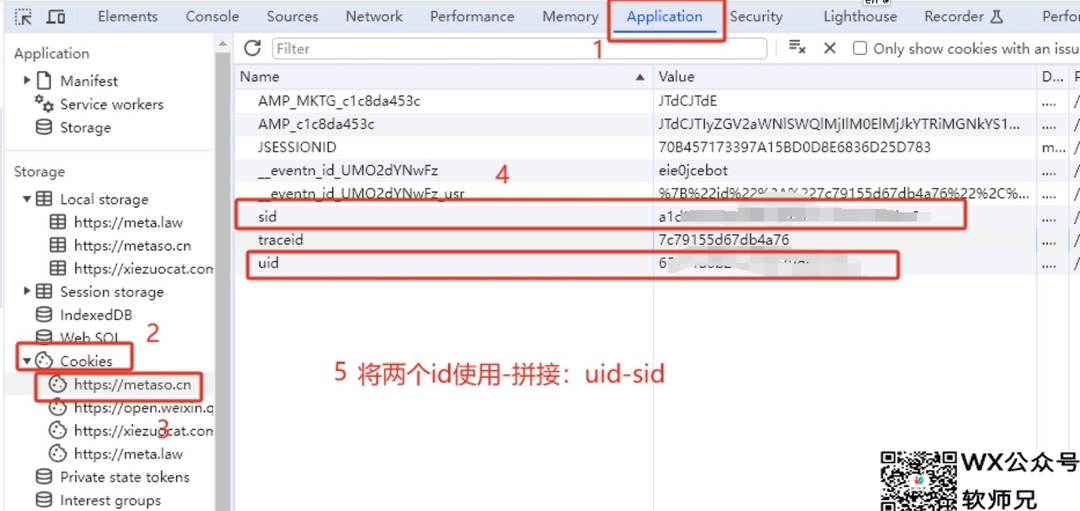

1、获取 Token

- 访问 秘塔AI 搜索 并发起对话。

- 打开开发者工具 (F12),在 Application -> Cookies 中找到 uid 和 sid 的值。

- 将 uid 和 sid 拼接:uid-sid,如 65e91a6b2bac5b600dd8526a-5e7acc465b114236a8d9de26c9f41846。

- 作为 Authorization 的 Bearer Token 值:Authorization: Bearer uid-sid

2、设置 Authorization Header:设置 Authorization: Bearer [uid-sid]。

3、发起请求:向 /v1/chat/completions 发送 POST 请求:

{

// 全网model名称支持 -> 简洁:concise / 深入:detail / 研究:research

// 学术model名称支持 -> 学术-简洁:concise-scholar / 学术-深入:detail-scholar / 学术-研究:research-scholar

// model乱填的话,可以通过tempature参数来控制(但不支持学术):简洁:< 0.4 / 深入:>= 0.4 && < 0.7 / 研究:>= 0.7

// model乱填的话,还可以通过消息内容包含指令来控制:↓↓↓

// 简洁 -> 简洁搜索小米su7 / 深入 -> 深入搜索小米su7 / 研究 -> 研究搜索小米su7

// 学术-简洁 -> 学术简洁搜索:小米su7 / 学术-深入 -> 学术深入搜索小米su7 / 学术研究 -> 学术研究搜索小米su7

// 优先级:model > 消息内容指令 > tempature

"model": "concise",

"messages": [

{

"role": "user",

"content": "秘塔AI"

}

],

// 如果使用SSE流请设置为true,默认false

"stream": false

}

4、接收响应

{

"id": "8466827997659213824",

"model": "concise",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "秘塔AI搜索是上海秘塔网络科技有限公司在2024年初推出的一款新产品,被誉为中国版Perplexity。它利用自研的大模型MetaLLM,能够直接对用户的提问进行理解和回答,提供结构化、准确、直接的搜索结果,并明确列出来源参考,无需科学上网,解决了语言理解上的误差[[1]]。秘塔AI搜索通过其强大的语义理解能力和全网搜索功能,为用户提供了一个高效、无广告、信息丰富的搜索体验[[2]]。此外,秘塔AI搜索的特点包括没有广告,直达结果;结构化信息展示;以及信息来源追溯,为每条搜索结果提供了来源链接,用户可以轻松溯源验证信息的出处和可靠性[[4]]。秘塔科技成立于2018年4月,是一家新锐科技公司,致力于运用AI技术赋能专业场景,进行技术研发与产品落地[[3]]。n"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 1,

"completion_tokens": 1,

"total_tokens": 2

},

"created": 1712859314

}

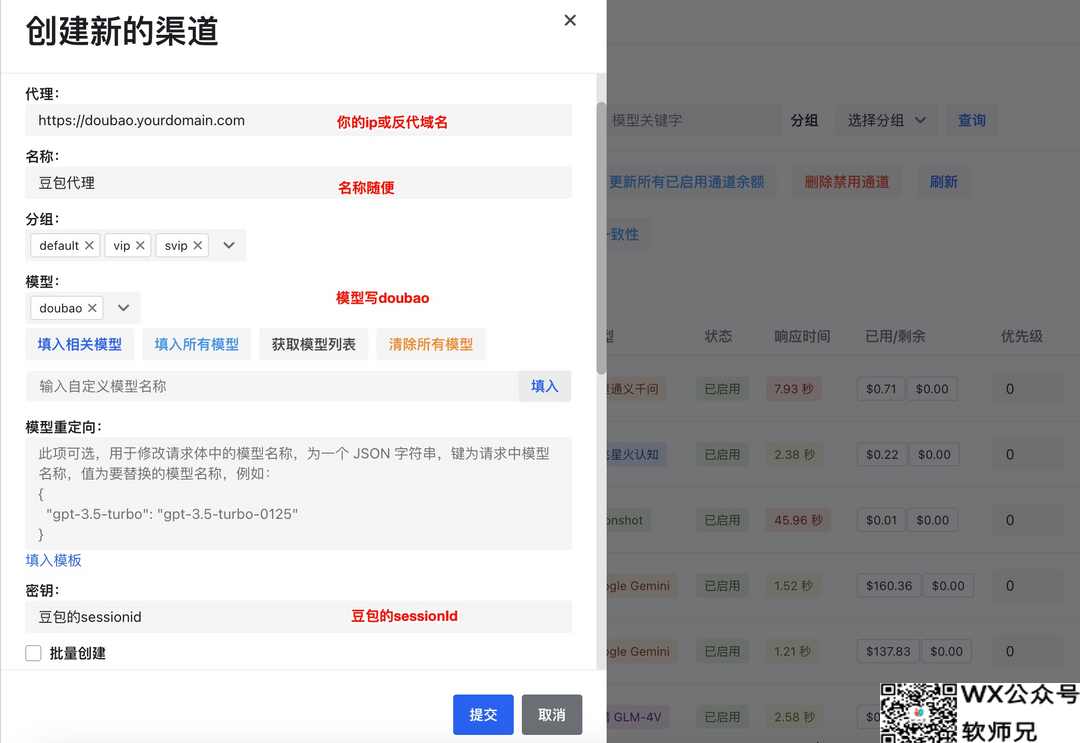

7️⃣ 字节跳动 💃:舞动AI的无限可能

doubao-free-api 通过逆向豆包,支持高速流式输出、秘塔 AI 超强联网搜索(全网 or 学术以及简洁、深入、研究三种模式),零配置部署,多路 token 支持。

🛠️ 启动方法

services:

doubao-free-api:

container_name: doubao-free-api

image: vinlic/doubao-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

保存为 docker-compose.yml,执行:

docker-compose up -d

🔑 使用方法

doubao-free-api 提供与 OpenAI 兼容的 /v1/chat/completions 接口。

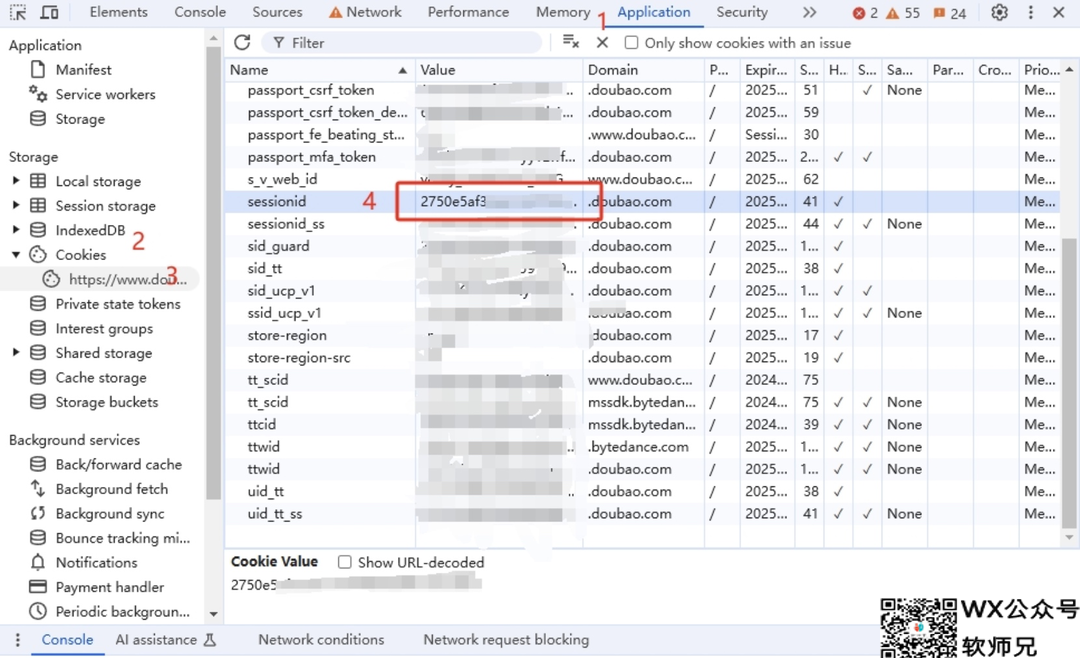

1、获取 Token

- 访问 豆包 并发起对话。

- 打开开发者工具 (F12),在 Application -> Cookies 中找到 sessionid 的值。

- 作为 Authorization 的 Bearer Token 值:Authorization: Bearer sessionid

2、设置 Authorization Header:设置 Authorization: Bearer [sessionId]。

3、发起请求:向 /v1/chat/completions 发送 POST 请求:

{

// 固定使用doubao

"model": "doubao",

// 目前多轮对话基于消息合并实现,某些场景可能导致能力下降且受单轮最大token数限制

// 如果您想获得原生的多轮对话体验,可以传入首轮消息获得的id,来接续上下文

// "conversation_id": "397193850580994",

"messages": [

{

"role": "user",

"content": "你叫什么?"

}

],

// 如果使用SSE流请设置为true,默认false

"stream": false

}

4、接收响应

{

// 如果想获得原生多轮对话体验,此id,你可以传入到下一轮对话的conversation_id来接续上下文

"id": "397193850645250",

"model": "doubao",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "我叫豆包呀,能陪你聊天、帮你答疑解惑呢。"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 1,

"completion_tokens": 1,

"total_tokens": 2

},

"created": 1733300587

}

8️⃣ 讯飞星火 🔥:点燃AI的智慧火花

spark-free-api 通过逆向讯飞星火,支持高速流式输出、多轮对话、联网搜索、智能体对话(计划支持)、AI 绘图(计划支持)、长文档解读(计划支持)、图像解析(计划支持),零配置部署,多路 token 支持,自动清理会话痕迹。

🛠️ 启动方法

services:

spark-free-api:

container_name: spark-free-api

image: vinlic/spark-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

保存为 docker-compose.yml,执行:

docker-compose up -d

🔑 使用方法

spark-free-api 提供与 OpenAI 兼容的 /v1/chat/completions 接口。

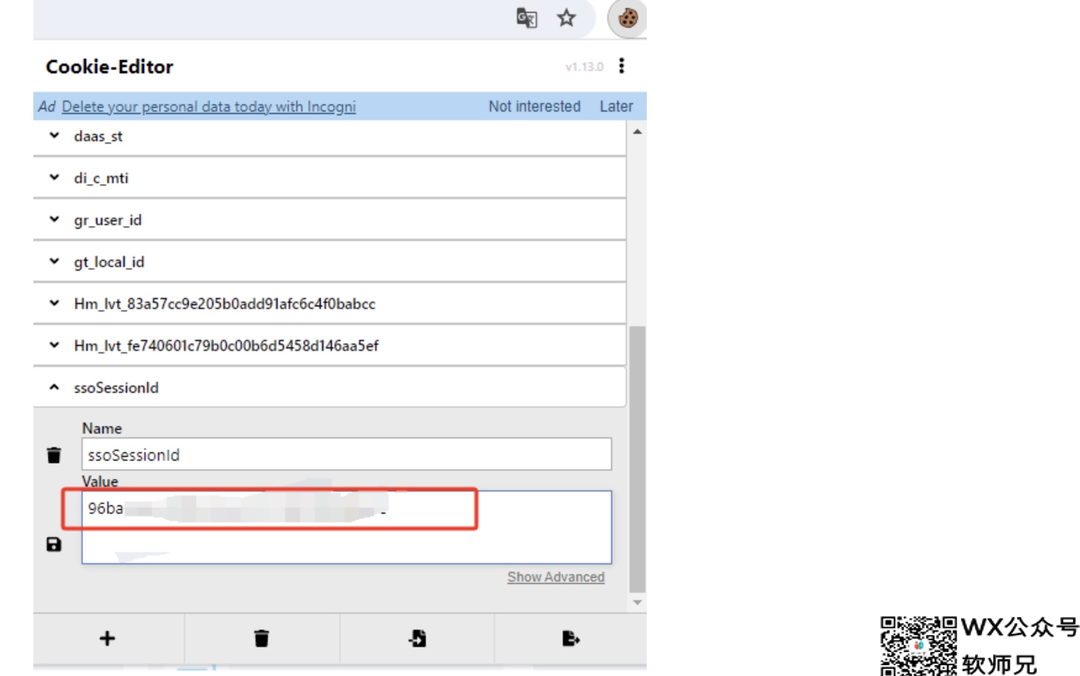

1、获取 Token

- 访问 讯飞星火 并发起对话,从 Cookie 获取 ssoSessionId 值

- 由于星火平台禁用 F12 开发者工具,请安装 Cookie-Editor 浏览器插件查看你的 Cookie。

- 作为 Authorization 的 Bearer Token 值:Authorization: Bearer ssoSessionId

2、设置 Authorization Header:设置 Authorization: Bearer [ssoSessionId]。

3、发起请求:向 /v1/chat/completions 发送 POST 请求:

{

// 模型名称随意填写,如果使用智能体请填写botId,如1662

// 可以从这里全局搜索找到你想用的智能体https://xinghuo.xfyun.cn/iflygpt/bot/home/get

"model": "spark",

// 目前多轮对话基于消息合并实现,某些场景可能导致能力下降且受最大token数限制

// 如果您想获得原生的多轮对话体验,可以传入首轮消息获得的id,来接续上下文,注意如果使用这个,首轮必须传none,否则第二轮会出现[belongerr]!

// "conversation_id": "331680774:cht000b6cfc@dx18f7a7ef0bab81c560",

"messages": [

{

"role": "user",

"content": "你是谁?"

}

],

// 如果使用SSE流请设置为true,默认false

"stream": false

}

4、接收响应

{

// 如果想获得原生多轮对话体验,此id,你可以传入到下一轮对话的conversation_id来接续上下文

"id": "331680774:cht000b6cfc@dx18f7a7ef0bab81c560",

"model": "spark",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "您好,我是科大讯飞研发的认知智能大模型,我的名字叫讯飞星火认知大模型。我可以和人类进行自然交流,解答问题,高效完成各领域认知智能需求。"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 1,

"completion_tokens": 1,

"total_tokens": 2

},

"created": 1715747089

}

9️⃣ MiniMax 🐚:小而美的AI世界

hailuo-free-api 通过逆向海螺 AI,支持最新 MiniMax-Text-01、MiniMax-VL-01 模型,支持高速流式输出、多轮对话、语音合成、语音识别、联网搜索、长文档解读、图像解析,零配置部署,多路 token 支持,自动清理会话痕迹。

🛠️ 启动方法

services:

hailuo-free-api:

container_name: hailuo-free-api

image: vinlic/hailuo-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

保存为 docker-compose.yml,执行:

docker-compose up -d

🔑 使用方法

hailuo-free-api 提供与 OpenAI 兼容的 /v1/chat/completions 接口。

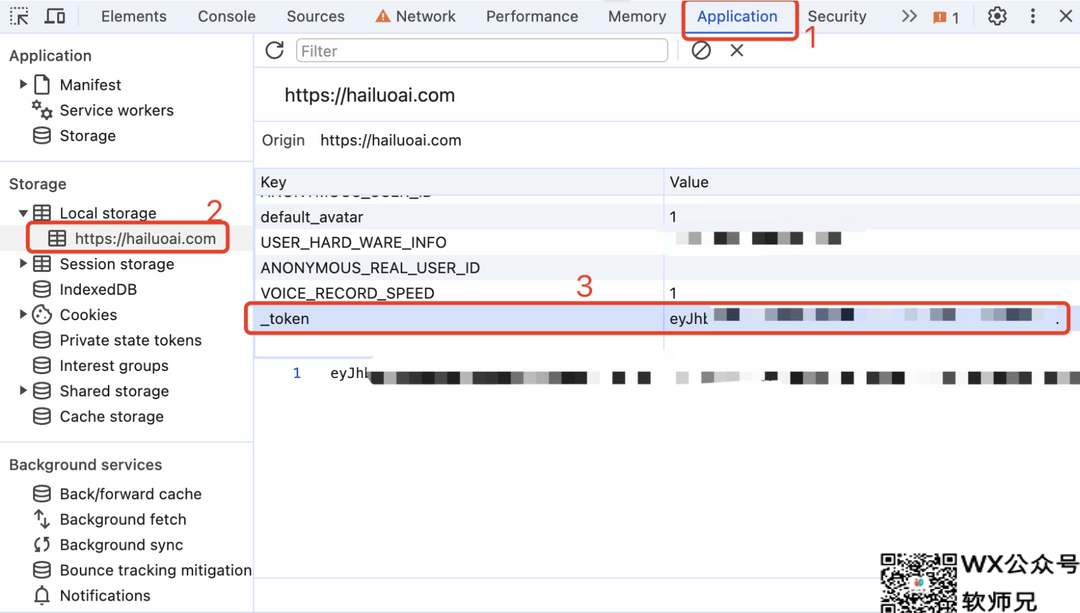

1、获取 Token

- 访问 海螺 AI 并发起对话,打开 F12 开发者工具,从 Application > LocalStorage 中找到 _token 的值

- 作为 Authorization 的 Bearer Token 值:Authorization: Bearer TOKEN

2、设置 Authorization Header:设置 Authorization: Bearer [TOKEN]。

3、发起请求:向 /v1/chat/completions 发送 POST 请求:

{

// model模型名称可以乱填

"model": "hailuo",

"messages": [

{

"role": "user",

"content": "你是谁?"

}

],

// 如果使用SSE流请设置为true,默认false

"stream": false

}

4、接收响应

{

"id": "242830597915504644",

"model": "hailuo",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "我是海螺AI,由上海稀宇科技有限公司(MiniMax)自主研发的AI助理。我可以帮助你回答各种问题,提供信息查询、生活建议、学习辅导等服务。如果你有任何问题,随时可以向我提问。"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 1,

"completion_tokens": 1,

"total_tokens": 2

},

"created": 1714751470

}

🔟 聆心智能 👂:倾听你的心声,理解你的情感

emohaa-free-api 通过逆向 Emohaa,支持高速流式输出、多轮对话,零配置部署,多路 token 支持,自动清理会话痕迹。

🛠️ 启动方法

services:

emohaa-free-api:

container_name: emohaa-free-api

image: vinlic/emohaa-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

保存为 docker-compose.yml,执行:

docker-compose up -d

🔑 使用方法

emohaa-free-api 提供与 OpenAI 兼容的 /v1/chat/completions 接口。

- 获取 Token

- 访问 Emohaa 并发起对话,从 LocalStorage 中获取 token 的值

- 由于 Emohaa 禁用 F12 开发者工具,请先安装 Manage LocalStorage 插件,再从在当前页面中打开插件并点击 Export 按钮找到 Token 的值,这将作为 Authorization 的 Bearer Token 值:Authorization: Bearer TOKEN

- 作为 Authorization 的 Bearer Token 值:Authorization: Bearer TOKEN

- 设置 Authorization Header:设置

Authorization: Bearer [TOKEN]。 - 发起请求:向

/v1/chat/completions发送 POST 请求:{

"messages": [

{

"role": "user",

"content": "你好"

}

],

// 如果使用SSE流请设置为true,默认false

"stream": false

}

- 接收响应

{

"id": "f73f02e6-6b43-4a46-ac24-3a9ea8d15145",

"model": "emohaa",

"object": "chat.completion",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": " 你好啊!我是Emohaa,想和我聊点什么吗? 今天心情如何?"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 1,

"completion_tokens": 1,

"total_tokens": 2

},

"created": 1710603111

}

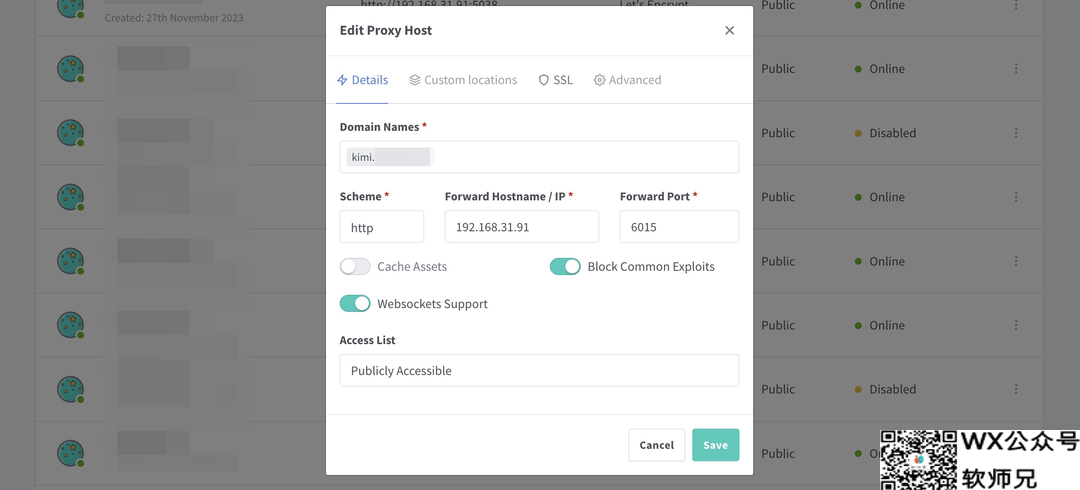

⚙️ Nginx 反向代理优化:丝滑体验,从配置开始 💫

如果您使用 Nginx 反向代理这些服务,请添加以下配置项优化流的输出效果,提升体验感。

# 关闭代理缓冲。当设置为off时,Nginx会立即将客户端请求发送到后端服务器,并立即将从后端服务器接收到的响应发送回客户端。

proxy_buffering off;

# 启用分块传输编码。分块传输编码允许服务器为动态生成的内容分块发送数据,而不需要预先知道内容的大小。

chunked_transfer_encoding on;

# 开启TCP_NOPUSH,这告诉Nginx在数据包发送到客户端之前,尽可能地发送数据。这通常在sendfile使用时配合使用,可以提高网络效率。

tcp_nopush on;

# 开启TCP_NODELAY,这告诉Nginx不延迟发送数据,立即发送小数据包。在某些情况下,这可以减少网络的延迟。

tcp_nodelay on;

# 设置保持连接的超时时间,这里设置为120秒。如果在这段时间内,客户端和服务器之间没有进一步的通信,连接将被关闭。

keepalive_timeout 120;

🔗 接入 one-api/new-api:统一管理,便捷调用 🧩

关于如何部署 one-api/new-api,笔者此前已经介绍过,不是本文重点,就不赘述了。注意类型选择 OpenAI即可。

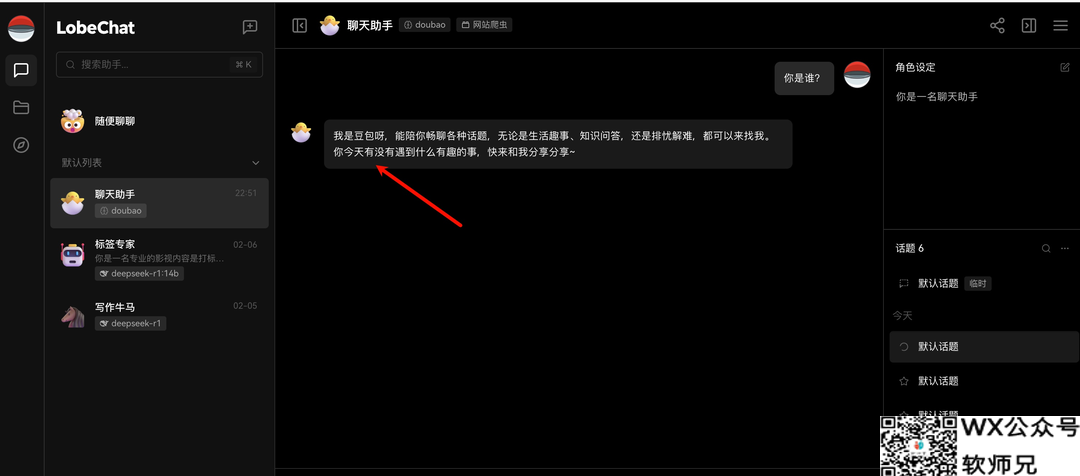

💬 LobeChat:与大模型畅聊,开启智能对话之旅 🤖

LobeChat 与 NextChat 几乎同期起步,二者也先后从开源走向商业化(除了开源,官方也提供商业服务)。不过个人感觉,LobeChat 在整体质感和功能特性方面更胜一筹。UI 精细现代,功能上支持语音合成、多模态、插件。

在“应用设置”-> “AI服务商”-> “OpenAI” 中填入 one-api 或 new-api 的地址和 API Key,就完成了全部的大模型接入。

——-大模型下载————–